2024.09.27 模型下线通知

by 史慧怡下线内容

平台将于 2024 年 10 月 11 日对部分模型进行下线处理。具体涉及的模型列表如下:

- 文本生成模型

- Qwen2-Math-72B

- 图像生成模型

- stabilityai/sd-turbo

- stabilityai/sdxl-turbo

- ByteDance/SDXL-Lightning

- TencentARC/PhotoMaker

- InstantX/InstantID

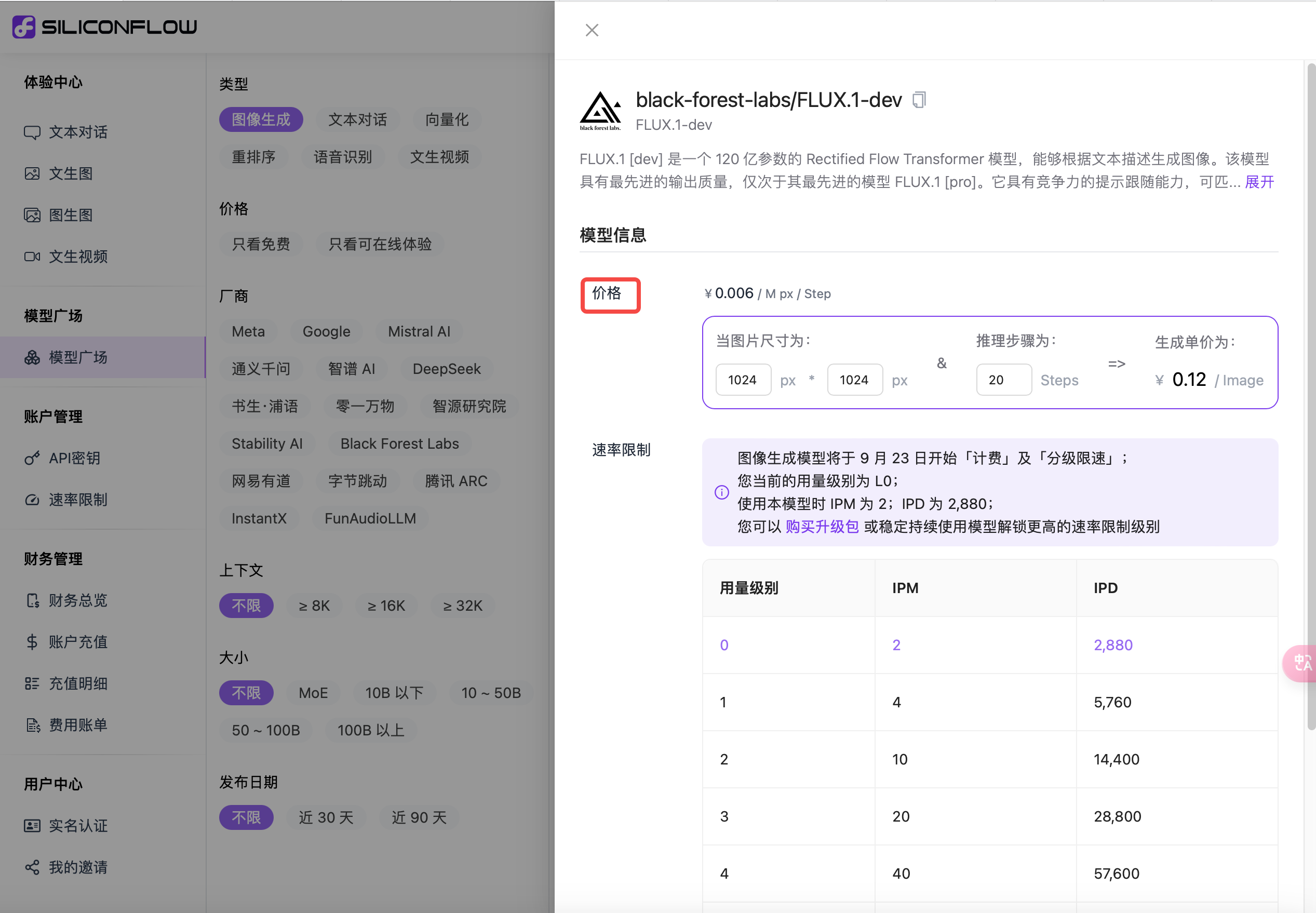

若您正在使用上述任一模型,建议您尽快迁移到 Qwen2.5-Math-72B、black-forest-labs/FLUX.1-dev 等同类型的模型,以免服务受到影响。为了给您提供更好的使用体验,SiliconCloud 团队承诺将提供全面支持,确保您平稳过渡至新服务。

下线时间

功能下线日期:2024 年 10 月 11 日

联系方式

我们期待这些新功能的加入能够为您带来更加丰富和高效的使用体验。如您在使用过程中有任何疑问或需要帮助,请 联系我们 进行反馈。