在沉浸式翻译中使用SiliconCloud API

在沉浸式翻译中,使用 SiliconCloud的API能力,达到快速跨语言翻译的目标

关于沉浸式翻译

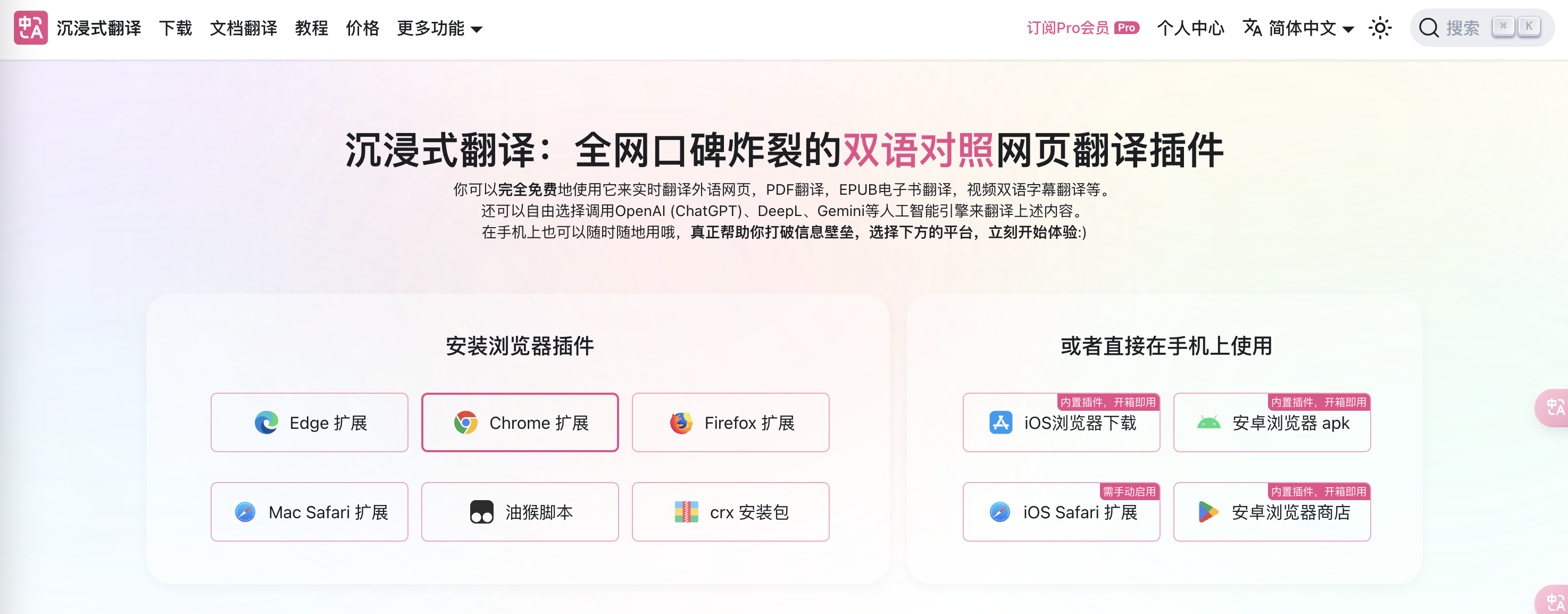

作为全网口碑炸裂的双语对照网页翻译插件,沉浸式翻译 结合大语言模型对于跨语言的理解能力,能够实时翻译外语内容,可应用于网页阅读,PDF 翻译,EPUB 电子书翻译,视频双语字幕翻译等场景,并支持各种浏览器插件和应用使用。自2023年上线以来,这款备受赞誉的 AI 双语对照网页翻译扩展,已帮助超过 100 万用户跨越语言障碍,自由汲取全球智慧。

硅基流动的 SiliconCloud近期第一时间提供了 GLM4、Qwen2、DeepSeek V2、Yi 等系列大模型,且模型速度非常快。如何将这二者结合起来,改善在沉浸式翻译场景的能力呢?

在沉浸式翻译中使用SiliconCloud API

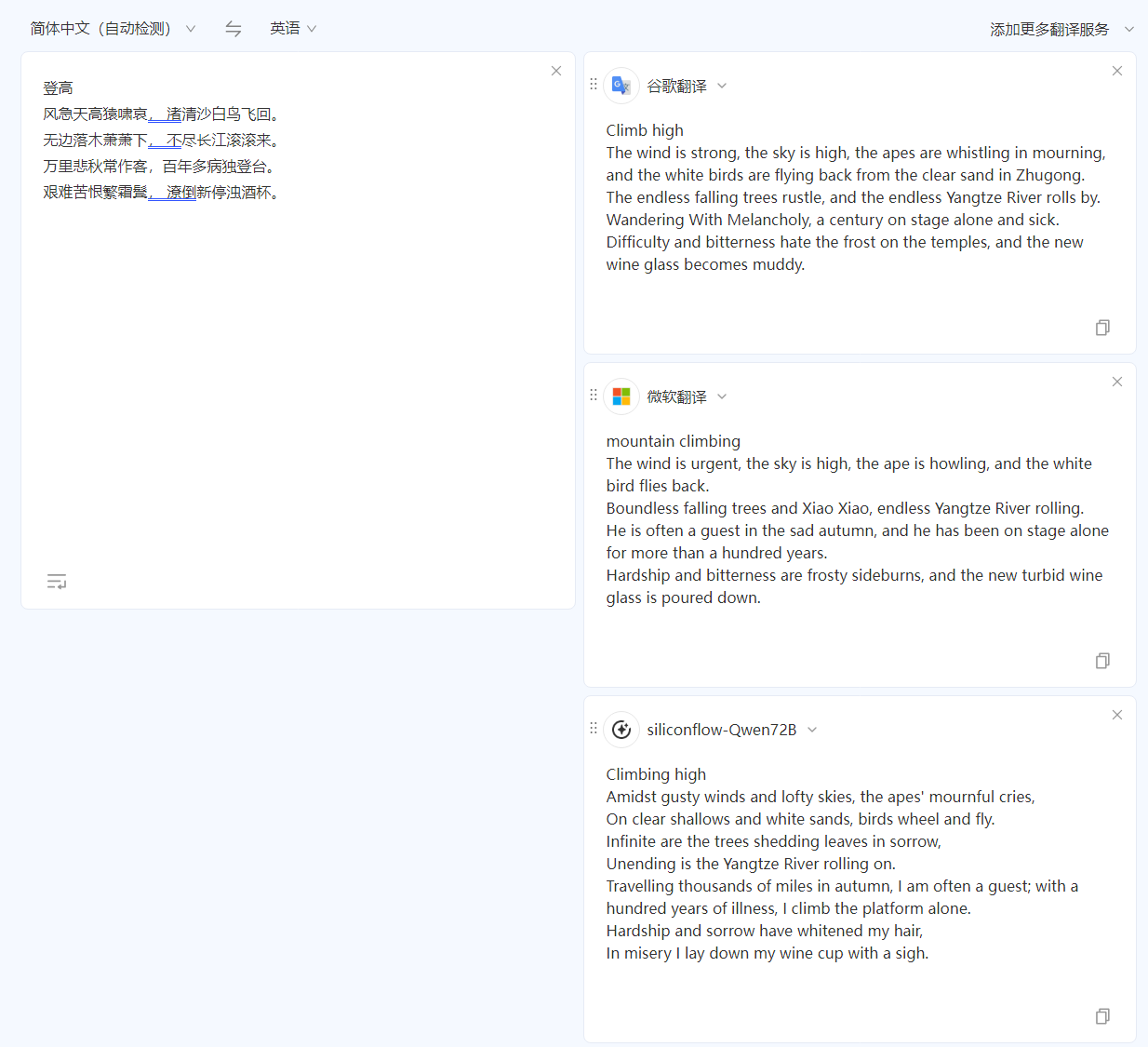

拿熟悉的中英互译进行说明。用杜甫经典的《登高》进行“中译英”测试,相比谷歌翻译和微软翻译,硅基流动提供的QWen 72B 模型对中文的理解更地道,译文也更贴近原文风格。

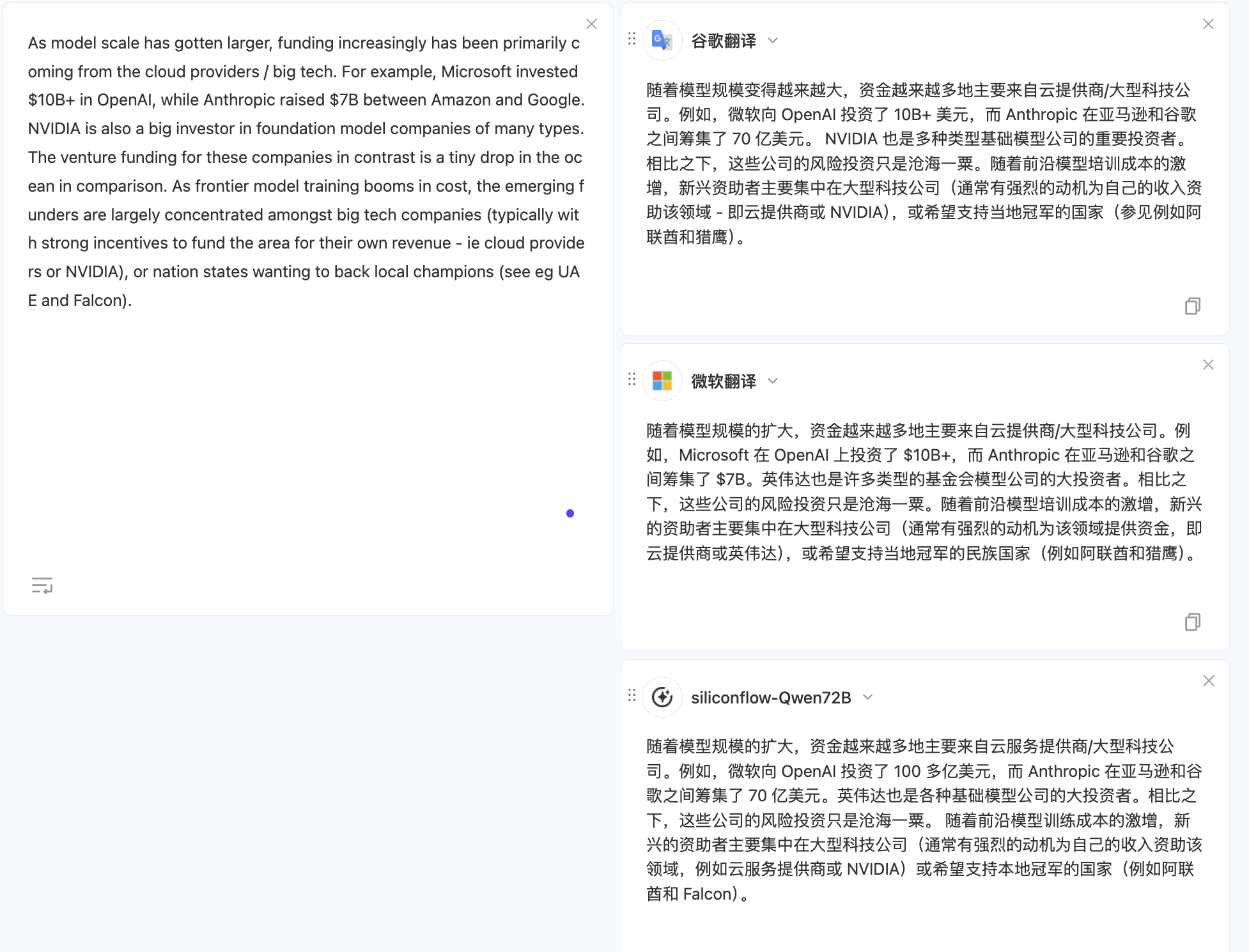

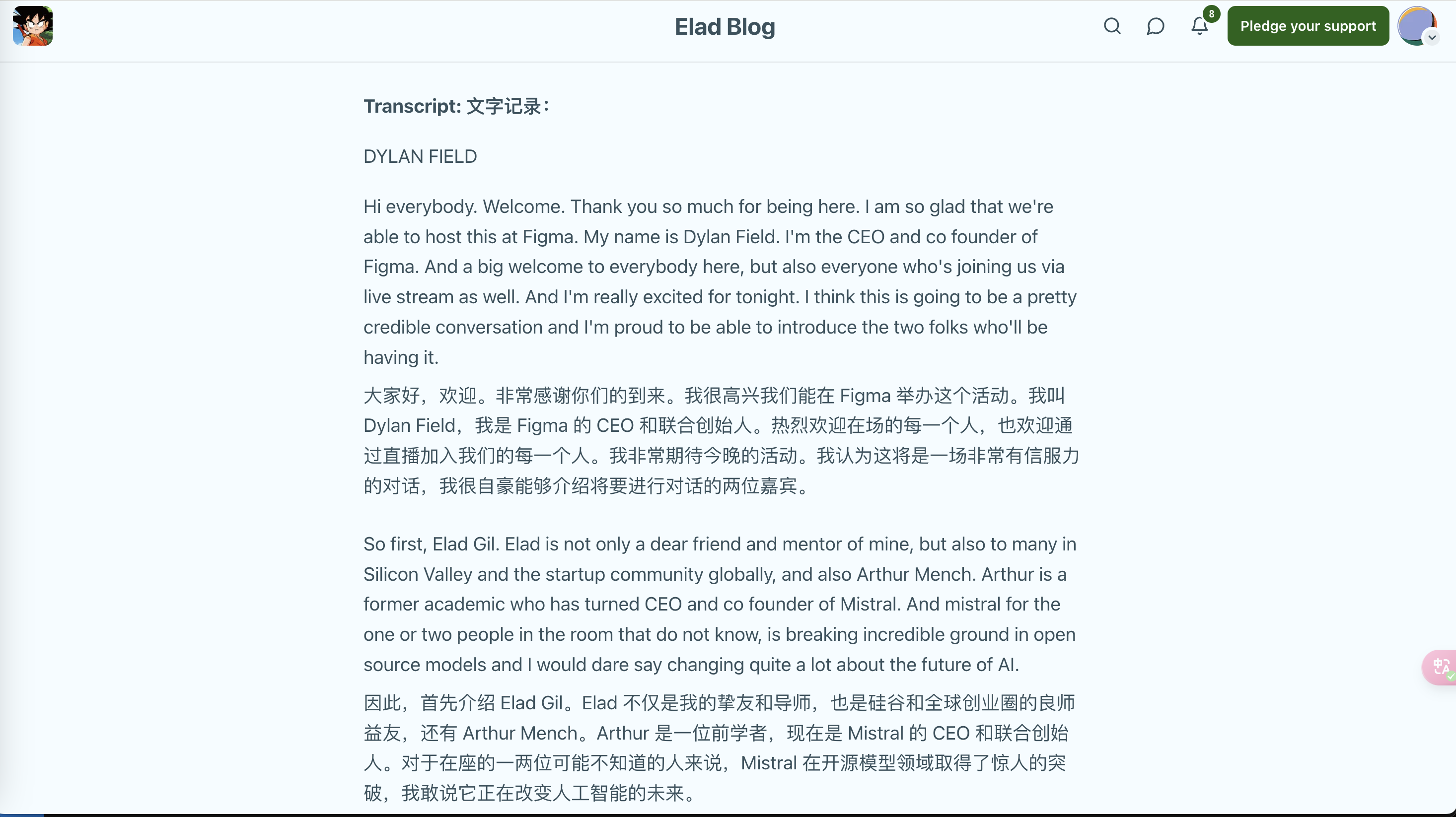

而同样基于同一段文本的“英译中”翻译,硅基流动提供的 模型也有更好的效果,译文更通顺流畅。

想要尝试其他场景,大家可以直接使用翻译文档多模型对比 进行测试,其中 SiliconCloud相关模型的配置详见“配置过程”部分。

配置过程

默认配置

- 在“沉浸式翻译”官网 选择“安装浏览器插件”,根据提示进行后续操作。如您已安装对应插件,请跳过本步骤。

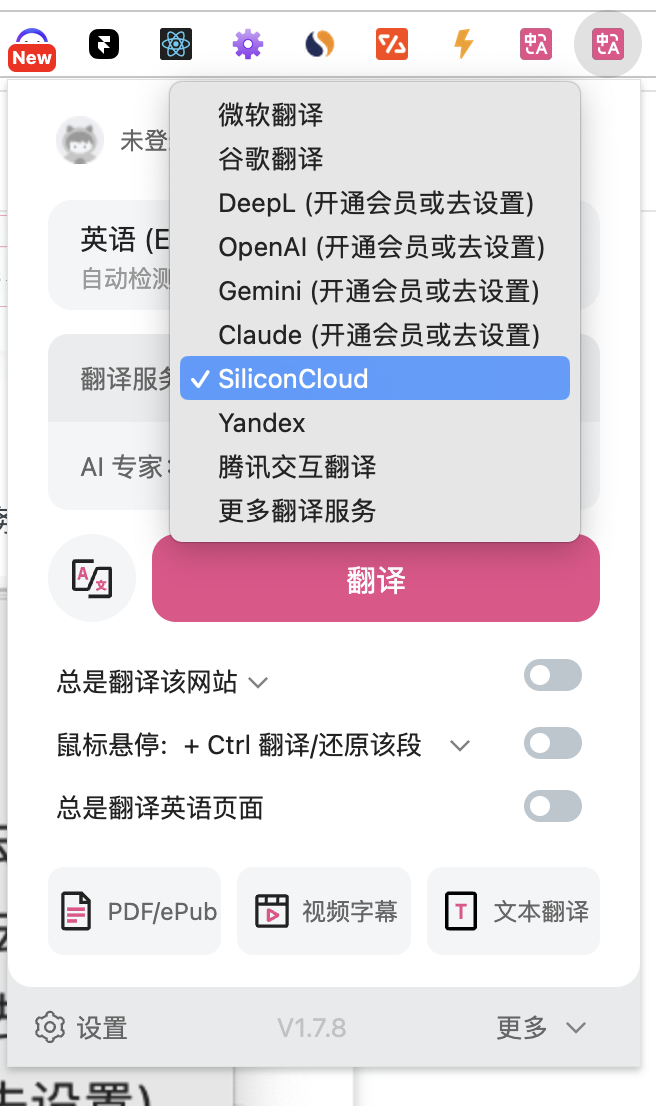

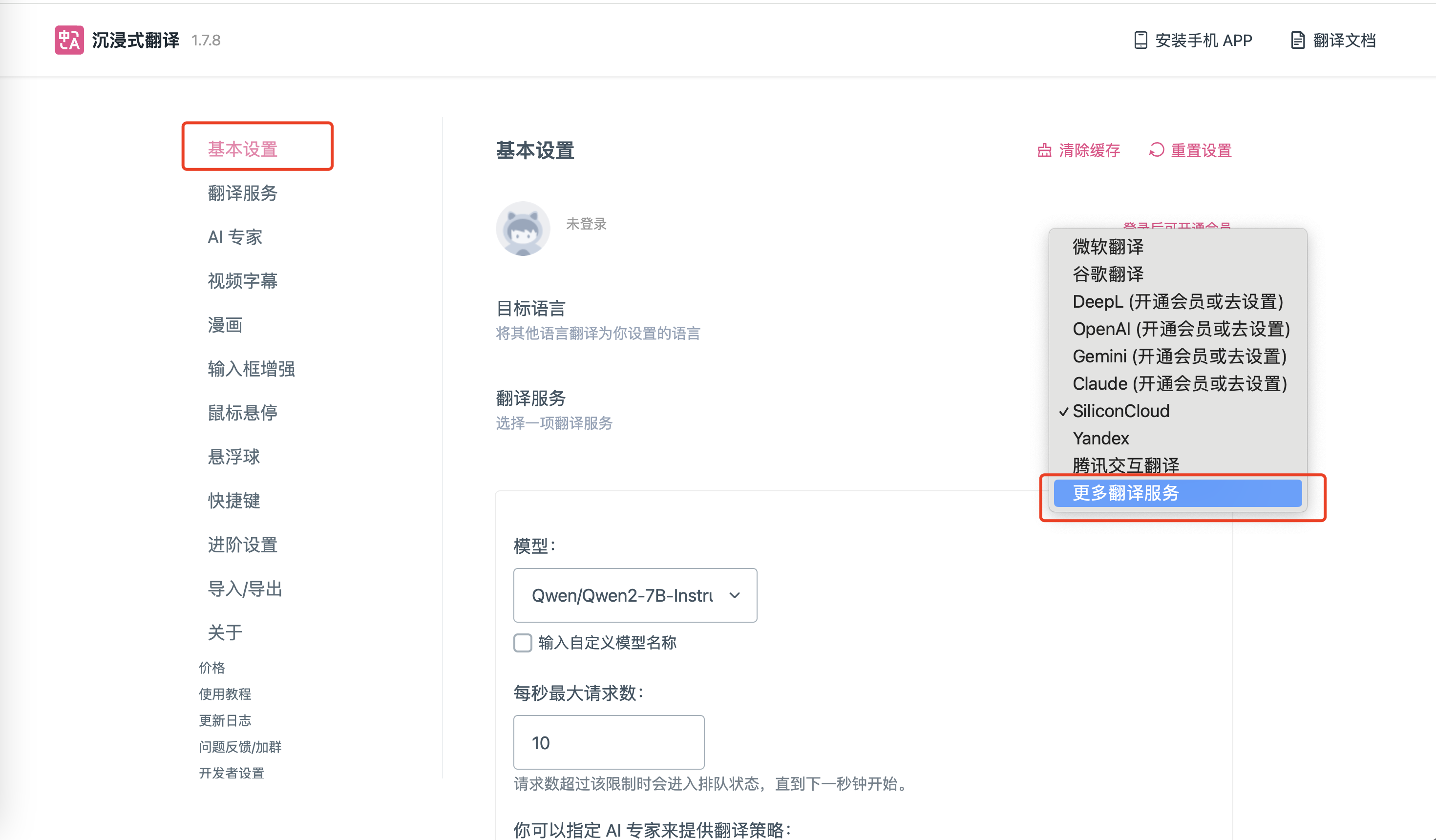

- 在沉浸式翻译的图标中将“翻译服务”设置为“SiliconCloud”即可使用SiliconCloud 的翻译服务。

以上就完成了默认设置。

在默认设置外选择SiliconCloud的其他免费模型:

- 上述设置中默认模型是SiliconCloud 的“Qwen/Qwen2-7B-Instruct”,如果需要切换到其他SiliconCloud的模型,点击上述图标中的“设置”,即可进行 SiliconCloud相关设置。

在默认设置外选择SiliconCloud的其他尺寸模型:

- 如果需要使用上述 8 个模型之外的其他SiliconCloud 模型,点击沉浸式翻译的扩展图标,找到对应“设置”选项,如下图所示,选择“更多翻译服务”。

- 在其中添加 SiliconCloud模型的相关信息

- 自定义翻译服务名称:按照自己的实际情况填写即可,此处我们填写为"Qwen/Qwen2-72B-Instruct"

- 自定义API 接口地址:

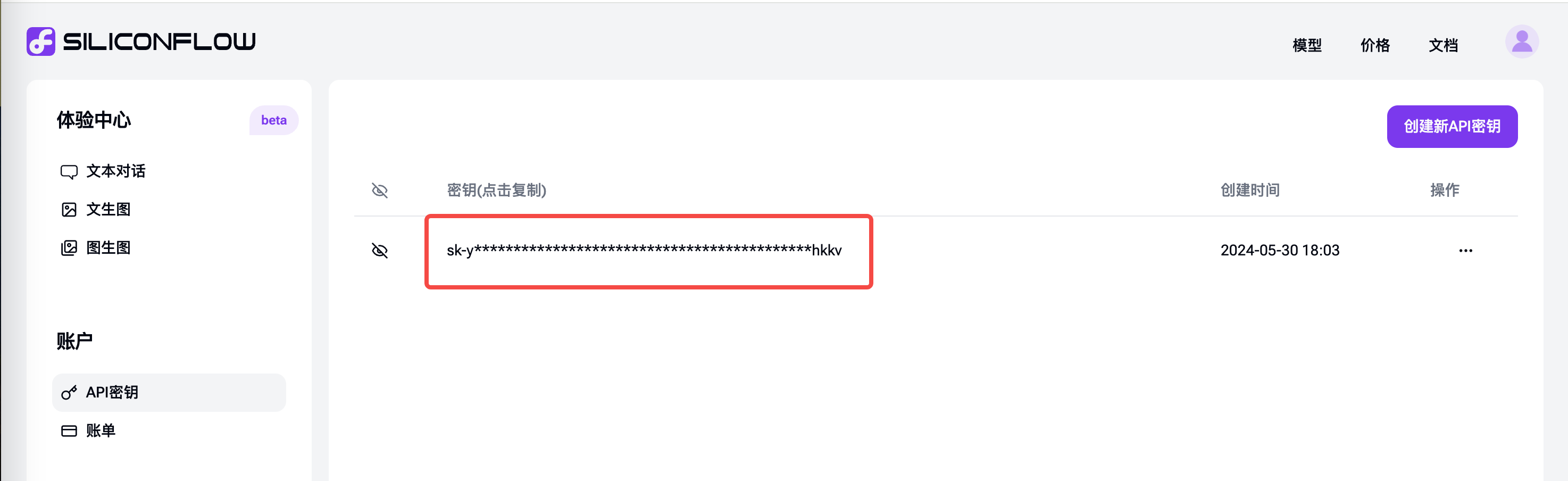

APIKEY:从API 密钥 中点击复制过来。

- 模型名称:模型在siliconcloud中的名称,此处为“Qwen/Qwen2-72B-Instruct”,可使用平台模型广场获得当前所有支持的模型名称。

- 点击右上角的测试,验证测试成功。

- 至此已经完成相关模型配置项,就可以在沉浸式翻译插件中使用SiliconCloud 提供的大语言模型来提供翻译了。

Updated 7 days ago